拆解AI造假四大套路:仿冒名人炮制新闻,换脸敲诈一键去衣

近日,有人用AI(人工智能)技术假冒知名医生张文宏带货的消息冲上热搜。15日,微信平台发布消息称,针对“利用AI技术仿冒名人进行不当营销”的情况进行了打击,关闭账号209个。AI作为一种新技术,面世以来被应用到社会多个领域,但近年来也出现了不少利用AI进行违法犯罪的案例,包括仿冒名人、造谣、换脸诈骗、窃取隐私等等。涉及AI的套路有哪些?如何厘清背后的利益链条?遇上类似情况该如何识别?我们一起来看看。

仿冒名人:炮制视频和声音

近日,有网友发现账号名为“般画XXX”发布的一段视频中,知名医生“张文宏”正在售卖一种蛋白棒。然而,媒体调查发现,该视频中口型和声音像是张文宏,售卖行为却非本人。经过核实,该视频并非张文宏医生本人拍摄,而是利用AI技术合成的虚拟人。据网友发布的截图显示,该蛋白棒产品已售出了1266份。事后,张文宏告诉央视记者,这样的卖货账号不止一个,而且一直在变,他已多次向平台投诉。

知名医生张文宏回应被AI仿冒带货。 央视财经截图

知名医生张文宏回应被AI仿冒带货。 央视财经截图

被AI技术假冒的,张文宏不是首个“躺枪”者。今年国庆假期,短视频平台上出现了大量“雷军AI配音”的视频,这些恶搞视频在社交平台上的相关话题浏览量过亿。视频中,“小米CEO雷军”锐评了堵车、调休、游戏等热门话题,言辞犀利,还常爆粗口。在事后接受采访时,雷军表示:“希望大家都不要玩了,这个事情不太好。”

今年11月,胖东来创始人于东来被人用AI技术生成声音去卖药,事后胖东来发布声明进行了辟谣。

据报道,今年11月,江西一位老人到银行办理业务,声称要贷款200万元给男朋友“靳东”拍戏。经调查发现,老人手机里的“靳东”出自由AI合成的视频。今年10月,老牌港星黄百鸣也通过社交媒体郑重声明,有人盗用其过去影片,利用AI替换声音,代言一个不知名的药膏品牌。

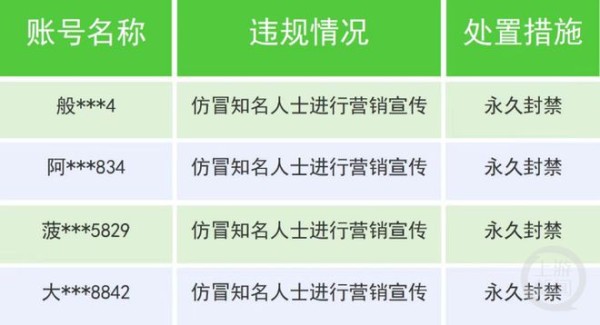

15日,微信平台发布消息称:“近期有媒体报道,网络存在利用AI技术仿冒名人进行不当营销的现象。我们从速从严打击了一批利用AI仿冒知名人士进行不当营销、恶意博取流量的违规行为,并针对相关情况开展专项治理。截至目前,累计处置内容532条,关闭账号209个。下一步,我们将持续对“利用AI仿冒知名人士进行营销宣传”等违规行为增 加打击力度。”

微信近期处理的部分违规账号。 “微信珊瑚安全”公众号

炮制新闻:软件几秒钟生成

当前,AI技术存在被滥用的情况,一些不法分子利用AI技术故意生成造谣内容并传播。

公安部网安局公布一起案例:2023年12月,一条“西安市鄠邑区地下涌出热水”的信息在网络上大量传播,出现如“地下出热水是因为发生了地震”“是因为地下热管道破裂”等谣言。经查,相关谣言是通过AI洗稿方式生成的。今年6月20日,上海警方也发布通报,两名品牌营销人员为蹭热度吸引流量,使用AI软件生成视频技术,编造“中山公园地铁 站捅人”等不实信息,相关人员已被行政拘留。

类似情况还有“济南一高层住宅楼起火,多人跳楼逃生”“晨练大爷在济南英雄山附近发现坟中有活人”……这些离谱的“重磅消息”引起大量关注,经有关部门调查,均系AI生成的谣言。

清华大学新闻与传播学院新媒体研究中心今年4月发布的一份研究报告显示,近两年的AI谣言中,经济与企业类谣言占比最高,达43.71%。近一年来,经济与企业类AI谣言量增速高达99.91%,其中餐饮外卖、快递配送等行业更是AI谣言重灾区。

法治日报记者用市面上流行的多款人工智能软件测试发现,只要给出关键词,就能在几秒钟内生成一篇“新闻报道”,只要加上时间地点,再配上图片和背景音乐,一篇以假乱真的“新闻报道”便制作完成。记者发现,很多AI生成的谣言中,都夹杂着“据报道”“相关部门正对事故原因进行深入调查,并采取措施进行抢修”“提醒广大市民在日常生活中要注意安全”等内容,在网上发布后人们往往难辨真伪。

中国人民大学新闻与社会发展中心研究员曾持说,AI根据热点事件总结规律、拼接情节,很快就能制作出符合人们“预期”的谣言,传播十分迅速。

换脸敲诈:有人被骗20万元

近年来,各地出现了不少利用AI技术直接参与犯罪的案例,犯罪分子利用AI进行换脸、换声,冒充他人进行诈骗,也有人利用AI窃取他人隐私。

马某某接到假冒表哥的视频电话。 央视新闻截图

马某某接到假冒表哥的视频电话。 央视新闻截图

宁夏固原市居民马某某接到表哥视频电话求助后,毫不犹豫给对方指定账户转了1.5万元。事后,他给亲戚发微信核实时才得知被骗,原来骗子通过AI换脸和拟声技术,佯装亲戚对其实施诈骗。

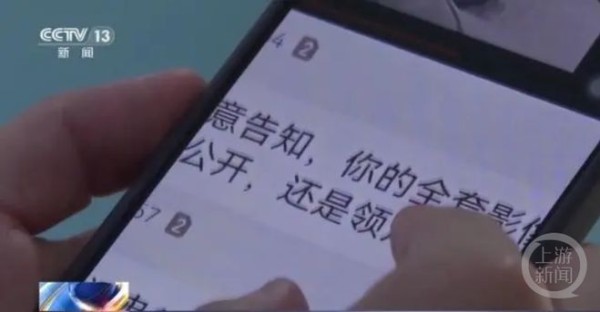

AI技术实现“一键去衣”和换脸的功能还被不法分子利用,成为敲诈勒索的工具。去年夏季,山东威海居民王某收到“自己和一名女子的裸照”,对方说“我有你全部的影像资料,赶紧跟我联系”,最后要求付款68万元。在没有多加核实的情况下,王某向敲诈团伙转账20万元。今年1月,威海警方赶赴浙江将两名犯罪嫌疑人抓获归案,为王某挽回了损失。

王某收到的敲诈信息。 央视新闻截图

王某收到的敲诈信息。 央视新闻截图

无独有偶,今年6月,深圳市民吴先生也遇到类似骗局,收到“自己和一名女子的裸照”,对方要求转账。吴先生随即报案,警方发现全市有同样遭遇的不止吴先生一人,犯罪嫌疑人的敲诈勒索方式都如出一辙。经过调查,警方打掉一个通过AI换脸技术合成不雅照,实施敲诈勒索的犯罪团伙,抓获嫌疑人10多人。

今年4月,北京市海淀区法院还审理了一起特殊的“制作、贩卖淫秽物品”案。被告白某某利用AI软件,对被害人的图片“一键去衣”,几秒钟、几分钟就能批量生成相应的图片。经查,他通过某款通讯软件向351个人贩卖相关图片,图片数量将近7000张。

白某某利用AI软件对被害人的图片“一键去衣”。 央视新闻截图

白某某利用AI软件对被害人的图片“一键去衣”。 央视新闻截图

今年9月,杭州警方公布了一起利用AI窃取民居隐私信息的案件。嫌疑人胡某某等四人,在境外网络承接定向出售国内头部平台用户数据业务,使用境外多模态专用大模型,通过文字对话,输出活体视频,突破平台人脸认证,强制登录他人账号,获取大量受害人私人数据和敏感信息并出售获利。据悉,这是全国首起利用AI技术侵犯公民个人信息的 案件。

克隆声音:网站当成生意做

利用AI技术进行犯罪,绝不是新技术的试错或无心之举,而是别有用心之人刻意利用新技术犯法乱纪,意图获取非法利益。

在上述北京发生的贩卖“去衣”照片案件中,被告白某某在境外社交媒体上接触到了这项“一键去衣”的技术,于是打算利用这项技术来赚钱,他在境外的社交媒体上发布了广告,内容就是“去衣”,1.5元一张。他的广告发布后,有不少人联系白某某,给他发送照片并购买这项“去衣”服务。

相关专家解释,“去衣”照片并不是真的去掉别人照片上的衣服,其实是针对已有的模型和已有的模组进行图片重绘。白某某不仅通过AI软件制作裸体图片贩卖牟利,同时出售AI“去衣软件”及使用教程牟利。短短几个月的时间,白某某制作了几千张去衣的图片,赚了近一万元钱。

另外,在多起AI造谣事件背后,造谣者的动机主要也是引流和借此牟利。今年6月中旬,一家MCN机构的实际控制人王某某利用AI软件生成虚假新闻并大肆传播,被警方行政拘留。据警方通报,王某某共经营5家MCN机构,运营账号842个,自今年1月以来,他通过AI软件生成虚假新闻,最高峰一天能生成4000至7000篇。另据西安警方介绍,他们查获了某款AI软件,“一天能生成19万篇文章”。今年2月,上海警方发现,在一家电商平台上出现了某艺人“命运多舛、含恨离世”等短视频,引发大量点赞和转发。经查,该视频内容系伪造。视频发布者交代,他通过假新闻给自己经营土特产的网店账号吸引流量,因自己不会视频剪辑,便利用AI技术生成虚假文本和视频。

雷军曾发视频回应遭AI配音恶搞。 网络图

在于东来、雷军等人曝出声音被克隆的消息后,有媒体记者搜索发现,网络平台上有不少AI克隆声音的教程视频。记者登上某网站发现,该网站已有大量训练好的声音模板,包括雷军、郭德纲、周杰伦、丁真等明星名人。其中,雷军的AI声音累计被使用的次数超过7万次,丁真AI声音模型使用次数超33万次,位于榜首。

生成AI声音十分简单。记者测试发现,对于已有模型的AI语音,只需输入想要生成的语音文本,3秒钟即可生成相应的音频。没有模型怎么办?根据该网站提示,只需上传最短10秒钟的语音素材,不到1分钟即可训练出新的声音模型,整个操作过程零技术门槛、零成本。也就是说,只要获取10秒钟的语音,任何人的声音都能被AI“偷走”,生成不实内 容。除了某些软件和网站外,网络购物平台上也有人工代做的服务销售,称“仅需一句话,克隆任何声音,还原度99.99%”。

如何防范:注意面部特征口型是否匹配

随着AI技术的迅猛发展,AI生成的信息使得公众难以辨别真伪。《2024年人工智能安全报告》显示,基于AI的深度伪造欺诈在2023年激增30倍。那么,普通人如何一眼识别换脸破绽,加以防范?中国网络空间安全协会人工智能安全治理专业委员会委员张博表示,如今AI换脸技术已经比较成熟,甚至能够实现视频通话的实时换脸,虽然单凭肉眼很难分辨,不过只要稍加留心,AI换脸还是有明显破绽,漏洞就在面部轮廓和光线上。

“视频通话时要仔细观察对方的面部轮廓是否存在异常的模糊情况,光线是否正常。”张博说,“如果有必要的话,可以要求对方快速大幅度地抬头、点头、转头,然后仔细观察这个过程中,面部轮廓是否有异常模糊。”

专家教大家如何辨别AI换脸。 央视新闻截图

专家教大家如何辨别AI换脸。 央视新闻截图

那么,我们又如何辨别AI换脸变声呢?中国移动(112.150, 3.36, 3.09%)信息安全与管理运行中心副经理王晓晴表示,一方面要检查面部特征,观察表情、动作以及声音和口型的匹配度;另一方面,核实信息来源,让对方用手遮住面部或进行其他面部动作判断画面是否连贯。

预防个人隐私信息泄露,也需要网民日常注意。专家称,不要泄露个人信息,尤其要注意图像、声音、指纹等生物信息的保护。AI换脸的数据基础是被模仿人的照片、视频等,个人公开在外的照片、视频越多,意味着AI算法参考的数据越多,生成的“数字人(19.050, -0.93, -4.65%)”会更真实。在涉及资金交易等场景下,需要多留心眼,不轻易相信视频、声音。很多时候,传统的识别方式要比技术识别更有效。

除了个人注意甄别和信息保护,我们也需要立法给AI技术应用套上法律缰绳。此前,我国已出台了《中华人民共和国网络安全法》《互联网信息服务算法推荐管理规定》《互联网信息服务深度合成管理规定》《生成式人工智能服务管理暂行办法》等法律、行政法规和部门规章。2023年,最高人民法院、最高人民检察院、公安部联合发布的《关于依法惩治网络暴力违法犯罪的指导意见》中规定,对“利用‘深度合成’等生成式人工智能技术发布违法信息”的情形,依法从重处罚。

今年9月14日,国家网信办起草的《人工智能生成合成内容标识办法(征求意见稿)》,目前已完成社会意见征集。该办法出台后,将进一步加强对AI生成技术的约束和规范,督促服务提供者和网络平台承担起应有的法律责任。上海人工智能研究院数字化治理中心主任彭嘉昊认为,面对每天产出的大量视频,监控、管理的难度相对而言比较大,约束这些服务的提供商才是综合治理这类事件的核心动作。

新闻延伸

四招预防个人信息泄露

陌生WiFi不要连

在公共场合连接免费WiFi时,极易碰到不法分子搭建的山寨WiFi。

钓鱼链接不要点

一些不法分子会假冒银行、学校等机构给用户发送短信或邮件,以“通知”“账户验证”等名义诱导用户点击其中的网址链接。

不明二维码不要扫

二维码应用场景十分广泛,而且制作简单、真伪难辨,常常被不法分子用于传播手机病毒和恶意软件。

个人信息不要晒

机票、证书、照片等内容中包含姓名、身份证号、手机号、关键位置等个人信息,如果随意晒在朋友圈等社交平台,可能会导致信息泄露。

上游新闻据光明日报、读特新闻、央视新闻、大众新闻、新京报、江西公安微信公众号、央视财经、法治日报等综合

海量资讯、精准解读,尽在新浪财经APP

网址:拆解AI造假四大套路:仿冒名人炮制新闻,换脸敲诈一键去衣 http://c.mxgxt.com/news/view/234075

相关内容

AI换脸灰色产业链浮现,女明星换脸75元套餐涉40余位6名在校大学生假冒明星实施敲诈被抓!警方通报

6名大学生假冒明星敲诈未成年人,两小学生被勒索5万多

起底名人明星“高仿号”利益链:假冒莫言,很赚钱吗?

AI换脸调查:淫秽视频可定制女星,700部百元打包卖

假靳东们7大行骗套路揭秘:炮制爱情、杀猪盘、“回馈”粉丝给100返300……

AI换脸产业链调查 女明星换脸淫秽视频成地下生意

人工智能:你是打击诈骗的奶奶,还是另一个网络骗子?—新闻—科学网

明星粉丝假冒媒体杜撰网文被立案侦查 网评发声遏制造假风气

杨幂被AI技术换脸惹争议 专家:亟待规范AI技术